ã¯ã˜ã‚ã«

ã“ã‚“ã«ã¡ã¯ã€‚ãƒãƒƒã‚¯ã‚¨ãƒ³ãƒ‰ã‚¨ãƒ³ã‚¸ãƒ‹ã‚¢ã®é½‹è—¤ã§ã™ã€‚

ã‚ã™ã‘ã‚“ã¯1,100万人以上ã®ä¼šå“¡æ§˜ã«åˆ©ç”¨ã„ãŸã ã„ã¦ãŠã‚Šã€ç‰¹ã«é£Ÿäº‹ã®æ™‚間帯ã«ã‚¢ã‚¯ã‚»ã‚¹ãŒé›†ä¸ã—ã¾ã™ã€‚ãã®ãŸã‚ã€ãƒ”ーク時ã®å¤§é‡ãƒªã‚¯ã‚¨ã‚¹ãƒˆã«ã‚‚対応ã§ãã‚‹ã‹ã‚’確èªã™ã‚‹è² è·ãƒ†ã‚¹ãƒˆãŒé‡è¦ã§ã™ã€‚

今回ã¯ã€ã€Œè² è·ãƒ†ã‚¹ãƒˆã€JMeterã£ã¦èžã„ãŸã“ã¨ã¯ã‚る…ã€ã¨ã„ã†çŠ¶æ…‹ã ã£ãŸç§ãŒã€åŠå¹´é–“ã§å¾—ãŸçŸ¥è¦‹ã‚’備忘を兼ãã¦ã¾ã¨ã‚ã¾ã™ã€‚

è² è·ãƒ†ã‚¹ãƒˆã¨ã¯

AWSã®ã“ã¡ã‚‰ã®è¨˜äº‹ãŒå‚考ã«ãªã‚Šã¾ã™ã€‚

負荷テスト on AWS のすすめ ~ 第 1 回 : 負荷テストの全体像を理解しよう - builders.flash☆ - 変化を求めるデベロッパーを応援するウェブマガジン | AWS

上記ã§é‡è¦ã¨æ„Ÿã˜ãŸéƒ¨åˆ†ã‚’抜粋ã—ã¾ã™ã€‚

- è² è·ãƒ†ã‚¹ãƒˆã¯é«˜è² è·ã‚’ã‹ã‘ã‚‹ã“ã¨ã§ã‚¢ãƒ—リケーションã®æ€§èƒ½ã‚’確èªã™ã‚‹ãƒ†ã‚¹ãƒˆ

- 性能ä¸è¶³ã«ã‚ˆã‚‹æ©Ÿä¼šæ失やユーザーã®é›¢åを防ããŸã‚ã«è¡Œã†

- 「性能ã€ã«ã¯ã€Œå‡¦ç†é‡ã€ã¨ã€Œå‡¦ç†æ™‚é–“ã€ã®2ã¤ã®è¦³ç‚¹ãŒã‚ã‚‹

- 具体的ã«ã¯ä»¥ä¸‹ã‚’確èªã™ã‚‹

- ピーク性能

- 予想ã•ã‚Œã‚‹ã‚¹ãƒ«ãƒ¼ãƒ—ット(å˜ä½æ™‚é–“ã‚ãŸã‚Šã®å‡¦ç†é‡ï¼‰ã‚’エラーやレスãƒãƒ³ã‚¹é…延ãªã処ç†ã§ãã‚‹ã‹

- é™ç•Œæ€§èƒ½

- 目標ã®ãƒ¬ã‚¹ãƒãƒ³ã‚¹ã‚¿ã‚¤ãƒ (リクエストã®å‡¦ç†ã«è¦ã—ãŸæ™‚間・パーセンタイル値ã§é›†è¨ˆï¼‰ã‚’éµå®ˆã—ãªãŒã‚‰ã€ã©ã‚Œã ã‘ã®ã‚¹ãƒ«ãƒ¼ãƒ—ットをæŒã‘ã‚‹ã‹

- 性能é™ç•Œåˆ°é”時ã®ãƒœãƒˆãƒ«ãƒãƒƒã‚¯ãŒã©ã“ã«ãªã‚‹ã‹

- ピーク性能

è² è·ãƒ†ã‚¹ãƒˆã®ç¨®é¡ž

AWSã®ã“ã¡ã‚‰ã®è¨˜äº‹ãŒå‚考ã«ãªã‚Šã¾ã™ã€‚

負荷テスト on AWS のすすめ ~ 第 2 回 : 負荷テストを計画しよう - builders.flash☆ - 変化を求めるデベロッパーを応援するウェブマガジン | AWS

今回ã¯ä¸»ã«ã€Œâ‘¡ãƒ”ーク性能試験ã€ã«ã¤ã„ã¦è§¦ã‚Œã¾ã™ã€‚

ピーク性能試験

- 想定ã™ã‚‹è² è·æ¯”çŽ‡ãƒ»è² è·é‡ã§ã‚ªãƒ³ãƒ©ã‚¤ãƒ³è² è·ã‚’ã‹ã‘ã€ç›®æ¨™æ€§èƒ½ã‚’満ãŸã›ã‚‹ã‹ã‚’確èª

ã©ã®ãらã„è² è·ã‚’ã‹ã‘ã‚‹ã‹

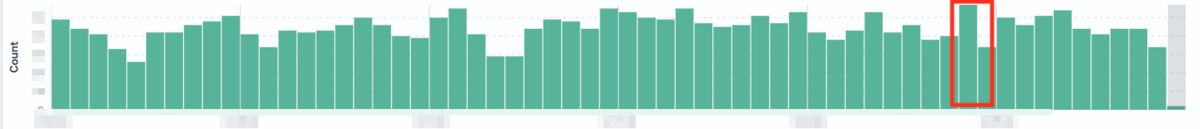

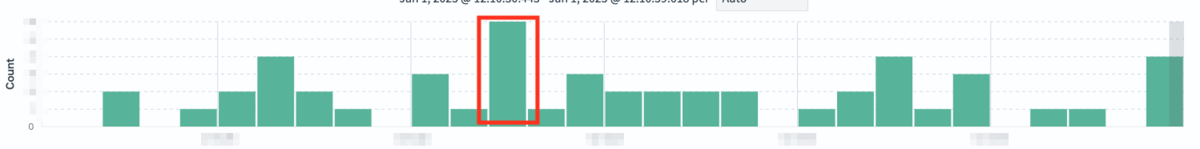

今回ã¯ãƒªã‚¢ãƒ¼ã‚テクãƒãƒ£ã‚’è¡Œã£ãŸAPIãŒãƒ†ã‚¹ãƒˆå¯¾è±¡ã§ã—ãŸã€‚ãã®ãŸã‚ã€ãƒªã‚¢ãƒ¼ã‚テクãƒãƒ£å‰ã®APIã®ç¾åœ¨ã®ãƒªã‚¯ã‚¨ã‚¹ãƒˆæ•°ã‚’基準ã«è² è·é‡ã‚’決定ã—ã¾ã—ãŸã€‚å‰è¿°ã®ã‚ˆã†ã«ã‚ã™ã‘ã‚“ã¯é£Ÿäº‹ã®æ™‚間帯ã«è² è·ãŒé›†ä¸ã™ã‚‹ãŸã‚ã€1æ—¥ã®ãƒªã‚¯ã‚¨ã‚¹ãƒˆæ•°ã®å¹³å‡ã§ã¯ãªãã€ä¸€ç•ªãƒ”ークã®ç§’ã®ãƒªã‚¯ã‚¨ã‚¹ãƒˆæ•°ã‚’基準ã«ã—ã¾ã—ãŸã€‚最大瞬間風速を基準ã«ã™ã‚‹ã‚¤ãƒ¡ãƒ¼ã‚¸ã§ã™ã€‚具体的ã«ã¯ã€ãƒ¡ãƒˆãƒªã‚¯ã‚¹ã‚’確èªã—ã¦ãƒªã‚¯ã‚¨ã‚¹ãƒˆãŒå¤šã„æ—¥ã®ãƒ”ーク時間を特定ã—ã€ãã®ä¸ã§åˆ†é–“データã€ç§’間データã¨åˆ†è§£ã—ã€æœ€ã‚‚リクエスト数ãŒå¤šã„ã‚‚ã®ã‚’採用ã—ã¦ã„ã¾ã™ã€‚ãã—ã¦ã€æŽ¡ç”¨ã—ãŸã‚‚ã®ã«å¯¾ã—ã¦ã€ŒÃ— 60ã€ã‚’ã—ãŸã‚‚ã®ã‚’「rpm (request per minutes)ã€ã¨å®šã‚ã¾ã—ãŸã€‚

ã¾ãŸã€ä»Šå›žã®å¯¾è±¡APIã¯æœ‰æ–™ãƒ¦ãƒ¼ã‚¶ãƒ¼å‘ã‘ã®æ©Ÿèƒ½ã§ã™ãŒã€æœŸé–“é™å®šã§ã®ç„¡æ–™é–‹æ”¾ã‚’予定ã—ã¦ã„ã¾ã—ãŸã€‚ãã®ãŸã‚ã€ç„¡æ–™é–‹æ”¾æ™‚ã®ãƒªã‚¯ã‚¨ã‚¹ãƒˆé‡ã‚‚予想ã—ã¦ã‚‚らã„ãã®æƒ³å®šã§ã®ãƒ†ã‚¹ãƒˆã‚‚è¡Œã„ã¾ã—ãŸã€‚有料ユーザーã¨ç„¡æ–™ãƒ¦ãƒ¼ã‚¶ãƒ¼ã®äººæ•°æ¯”ã‹ã‚‰äºˆæ¸¬ã—ã¦ã‚‚らã£ãŸã®ã§ã™ãŒã€ç„¡æ–™é–‹æ”¾æœŸé–“ä¸ã«ç¢ºèªã—ãŸã¨ã“ã‚ã€ã»ã¨ã‚“ã©ãã®é€šã‚Šã®ãƒªã‚¯ã‚¨ã‚¹ãƒˆæ•°ã¨ãªã£ã¦ãŠã‚Šã€ã“ã®ã‚ˆã†ã«äºˆæ¸¬ã™ã‚Œã°ã‚ˆã„ã®ã‹ã¨å‹‰å¼·ã«ãªã‚Šã¾ã—ãŸã€‚

è² è·ã‚’ã‹ã‘るツール

今回ã¯è©³ã—ã記載ã—ã¾ã›ã‚“ãŒã€JMeter 㨠AWS Distributed Load Testing (以下DLTã¨ã™ã‚‹) を利用ã—ã¦è¡Œã„ã¾ã—ãŸã€‚(別ã®æ©Ÿèƒ½ã®è² è·ãƒ†ã‚¹ãƒˆã«ã¦æ§‹ç¯‰æ¸ˆã¿ã§ã—ãŸã®ã§ã€ãã®ã¾ã¾ä½¿ã‚ã›ã¦ã‚‚らã„ã¾ã—ãŸã€‚)

一度JMeterをアップãƒãƒ¼ãƒ‰ã—ãŸå¾Œã¯ã€JMeterã®ã‚·ãƒŠãƒªã‚ªã‚’変更ã›ãšã«ã€ç”»é¢ã‹ã‚‰ã‚¿ã‚¹ã‚¯æ•°ã¨ã‚¹ãƒ¬ãƒƒãƒ‰æ•°ã‚’調整ã™ã‚‹ã“ã¨ã§ç°¡å˜ã«è² è·é‡ã‚’変更ã§ãã‚‹ã®ãŒä¾¿åˆ©ã§ã—ãŸã€‚

以下ã«è©³ã—ã„説明ãŒã‚ã‚Šã¾ã™ã€‚

負荷テスト on AWS のすすめ ~ 第 3 回 : 負荷テストを準備・実施しよう - builders.flash☆ - 変化を求めるデベロッパーを応援するウェブマガジン | AWS

çµæžœã®ç¢ºèª

è² è·ã‚’ã‹ã‘終ã‚ã£ãŸã‚‰çµæžœã‚’確èªã—ã¾ã™ã€‚

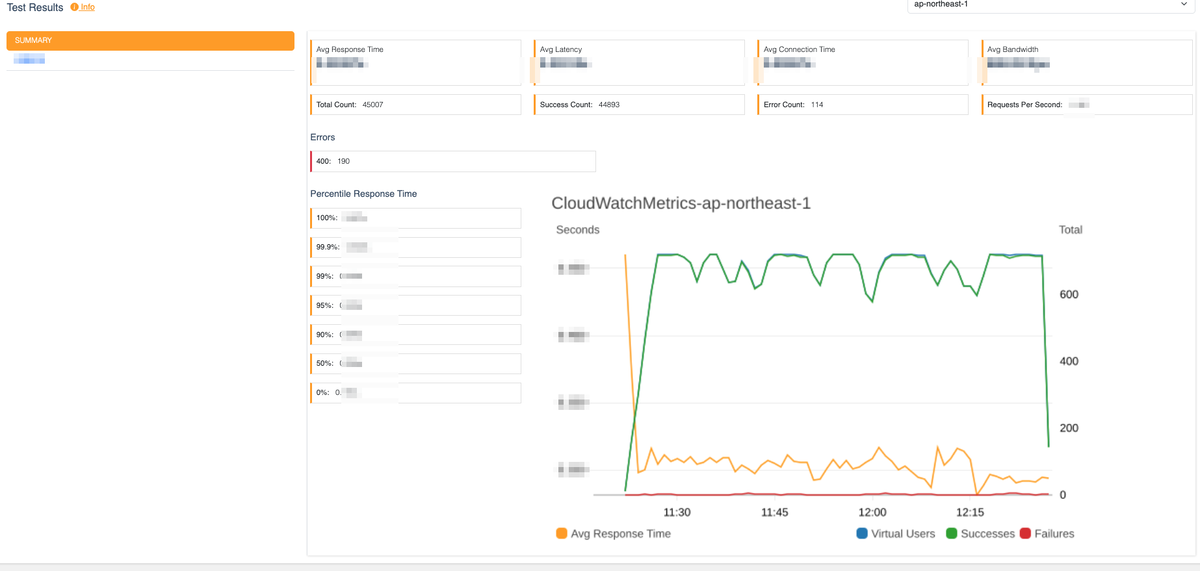

ã¾ãšã¯ã€DLT上ã§ãƒ¬ã‚¹ãƒãƒ³ã‚¹ã‚¿ã‚¤ãƒ ã¨ã€ã‚¨ãƒ©ãƒ¼ãŒç™ºç”Ÿã—ã¦ã„ãªã„ã‹ã‚’確èªã—ã¾ã™ã€‚DLTã®çµæžœç”»é¢ã§ã¯ã€ãƒ¬ã‚¹ãƒãƒ³ã‚¹ã‚¿ã‚¤ãƒ ã®å¹³å‡ã®ä»–ã€å„パーセンタイルã§ã®ãƒ¬ã‚¹ãƒãƒ³ã‚¹ã‚¿ã‚¤ãƒ も表示ã—ã¦ãã‚Œã¾ã™ã€‚

例:「95 パーセンタイル㧠1秒以内(全リクエストã®ã†ã¡ 95% ㌠1秒以内ã«çµ‚了ã™ã‚‹ï¼‰ã€

ãã®å¾Œã€é€¼è¿«ã—ãŸçŠ¶æ³ã¨ãªã£ã¦ã„るリソースãŒãªã„ã‹ã‚’確èªã—ã¾ã™ã€‚askenã§ã¯NewRelicを利用ã—ã¦ã„ã‚‹ãŸã‚ã€NewRelicã®ãƒ€ãƒƒã‚·ãƒ¥ãƒœãƒ¼ãƒ‰ã‚’作りã€ä¸€è¦§ã§ç¢ºèªã§ãるよã†ã«ã—ã¾ã—ãŸã€‚NewRelicã«é€£æºã—ã¦ã„ãªã„メトリクスã¯ã€AWS上ã§ç¢ºèªã—ã¾ã—ãŸã€‚ï¼ˆè² è·ãƒ†ã‚¹ãƒˆå®Ÿæ–½æ™‚ã¯çŸ¥ã‚‰ãªã‹ã£ãŸã®ã§ã™ãŒã€AWSã§ã‚‚ダッシュボードを作る機能ãŒã‚ã‚‹ãŸã‚ã€ä»Šå¾Œã¯AWSå´ã§ãƒã‚§ãƒƒã‚¯ã—ãŸã„メトリクスもダッシュボードを作ã£ã¦ä¸€è¦§ã§ç¢ºèªã§ãるよã†ã«ã—ãŸã„ã§ã™ã€‚)

ã‚‚ã—çµæžœã‚’確èªã—ã¦ã€æœŸå¾…ã™ã‚‹ãƒ¬ã‚¹ãƒãƒ³ã‚¹ã‚¿ã‚¤ãƒ ã«é”ã—ã¦ã„ãªã„å ´åˆã¯ã€ã©ã“ã§æ™‚é–“ãŒã‹ã‹ã£ã¦ã„ã‚‹ã‹ã‚’確èªã—ã¾ã™ã€‚NewRelicã® Distributed tracing ã®æ©Ÿèƒ½ã¯ã€ã©ã“ã§æ™‚é–“ãŒã‹ã‹ã£ã¦ã„ã‚‹ã‹ãŒã‚ã‹ã‚Šã‚„ã™ãã€ä¾¿åˆ©ã§ã—ãŸã€‚

ã‚‚ã—エラーãŒç™ºç”Ÿã—ã¦ã„ã‚‹å ´åˆã¯ã€ãƒã‚°ã‹ã‚‰ã©ã“ã§ã‚¨ãƒ©ãƒ¼ãŒç™ºç”Ÿã—ã¦ã„ã‚‹ã‹ç¢ºèªã—ã¾ã™ã€‚

性能以外ã§ç¢ºèªã—ãŸãƒã‚¤ãƒ³ãƒˆ

性能以外ã«ã€ä»¥ä¸‹ã‚‚確èªã—ã¾ã—ãŸã€‚

- å¯ç”¨æ€§

スケールイン・スケールアウトやデプãƒã‚¤æ™‚・データ入れ替ãˆæ™‚ãªã©ã«ã‚‚ã€ã‚·ã‚¹ãƒ†ãƒ ãŒåˆ©ç”¨ã§ãる状態ã§ã‚ã‚‹ã‹ã€‚

- é‹ç”¨æ€§

エラー発生時ã«ãƒã‚°ã§åŽŸå› ã®ç‰¹å®šãŒã§ãã‚‹ã‹ã‚„ã€ãƒªã‚½ãƒ¼ã‚¹é€¼è¿«æ™‚ã«ã‚¢ãƒ©ãƒ¼ãƒˆã§æ°—ãŒã¤ãã“ã¨ãŒã§ãã‚‹ã‹ã€‚

- é©åˆ‡ãªã‚¹ãƒšãƒƒã‚¯ã‹

エラーやレスãƒãƒ³ã‚¹é…延ãŒèµ·ãã¦ãŠã‚‰ãšãƒªã‚½ãƒ¼ã‚¹ã‚‚逼迫ã—ã¦ã„ãªã‹ã£ãŸå ´åˆã€é€†ã«é«˜ã™ãŽã‚‹ã‚¹ãƒšãƒƒã‚¯ã‚’指定ã—ã¦ç„¡é§„ãªã‚³ã‚¹ãƒˆãŒã‹ã‹ã£ã¦ã„ãªã„ã‹ã€‚(å„種利用率ãªã©ã‚’見ã¦ã€å°‘ã—ã—ã‹åˆ©ç”¨ã—ã¦ã„ãªã„ã‚‚ã®ãŒã‚ã‚‹å ´åˆã¯ã€ãã®éƒ¨åˆ†ã‚’下ã’られるã‹æ¤œè¨Žã™ã‚‹ã®ãŒã‚ˆã„よã†ã§ã™ãŒã€ã©ã®ã‚ãŸã‚ŠãŒé©åˆ‡ãªã®ã‹è¦‹æ¥µã‚ã‚‹ã®ã¯ã¾ã 修行ãŒå¿…è¦ã¨æ„Ÿã˜ã¦ã„ã¾ã™ã€‚)

åçœãƒ»æ³¨æ„点

実施ã—ã¦ã¿ã¦æ³¨æ„ãŒå¿…è¦ã¨æ„Ÿã˜ãŸç‚¹ã‚„åçœç‚¹ã§ã™ã€‚

実施ä¸

- è² è·ã‚’ã‹ã‘始ã‚ã¦å°‘ã—ã—ãŸã‚‰çŠ¶æ³ã‚’確èªã™ã‚‹

終ã‚ã£ãŸå¾Œã«ç¢ºèªã—ãŸã‚‰ã€ãƒ†ã‚¹ãƒˆãƒ‡ãƒ¼ã‚¿ã‚„ユーザーã‚ãŸã‚Šã®ãƒªã‚¯ã‚¨ã‚¹ãƒˆé‡ä¸Šé™ãªã©ã«ã‚ˆã‚Šã‚¨ãƒ©ãƒ¼ãŒç™ºç”Ÿã—ã¦ãŠã‚Šã€å†å®Ÿæ–½ã—ãŸã“ã¨ãŒã‚ã‚Šã¾ã—ãŸã€‚è² è·ã‚’ã‹ã‘始ã‚ã¦å°‘ã—ã—ãŸã‚‰ã€å•é¡Œãªã実行ã•ã‚Œã¦ã„ã‚‹ã‹ç¢ºèªã™ã‚‹ã®ãŒè‰¯ã•ãã†ã§ã™ã€‚

- å•é¡ŒãŒèµ·ããŸæ™‚ã«æœŸé–“を決ã‚ã¦èª¿æŸ»ã™ã‚‹ã€‚期間内ã«è§£æ±ºã§ããªã‹ã£ãŸã‚‰ä»–ã®æ–¹æ³•ã‚’探る

è² è·ã‚’ã‹ã‘ãŸå ´åˆã®ã¿ã€ã‚るライブラリã®åˆ©ç”¨ç®‡æ‰€ã§ã‚¨ãƒ©ãƒ¼ãŒç™ºç”Ÿã—ãŸçŠ¶æ³ã§ã€ãã®ãƒ©ã‚¤ãƒ–ラリを使ã†å‰æã§ã®èª¿æŸ»ã‚„試行錯誤ã«æ™‚é–“ã‚’ã‹ã‘ã¦ã—ã¾ã„ã€çµå±€ä»–ã®æ–¹æ³•ã§å®Ÿè£…ã—ãªãŠã™æ–¹ãŒæ—©ã‹ã£ãŸã¨ã„ã†ã“ã¨ãŒã‚ã‚Šã¾ã—ãŸã€‚è² è·ãƒ†ã‚¹ãƒˆã§ç™ºç”Ÿã™ã‚‹å•é¡Œã¯è¤‡é›‘ãªã“ã¨ã‚‚多ã„ã®ã§ã€èª¿æŸ»ã®æœŸé–“を決ã‚ã€æœŸé–“内ã«ç³¸å£ãŒè¦‹ã¤ã‹ã‚‰ãªã„å ´åˆã¯åˆ¥ã®æ–¹æ³•ã‚’検討ã™ã‚‹ã®ãŒè‰¯ã„よã†ã§ã™ã€‚

- 後ã‹ã‚‰è¦‹ã¦ã‚ã‹ã‚‹ã‚ˆã†ã«ã€å®Ÿæ–½æ—¥æ™‚・å„リソースã®ã‚¹ãƒšãƒƒã‚¯ãƒ»è² è·è¨å®šãƒ»çµæžœã‚’記録ã—ã¦ãŠã

実施日時・å„リソースã®ã‚¹ãƒšãƒƒã‚¯ãƒ»è² è·è¨å®šãƒ»çµæžœã‚’記録ã—ã¦ãŠãã¨ã€å¾Œã‹ã‚‰è¦‹ãŸéš›ã‚‚ã‚ã‹ã‚Šã‚„ã™ã„ã§ã™ã€‚

メトリクス関連

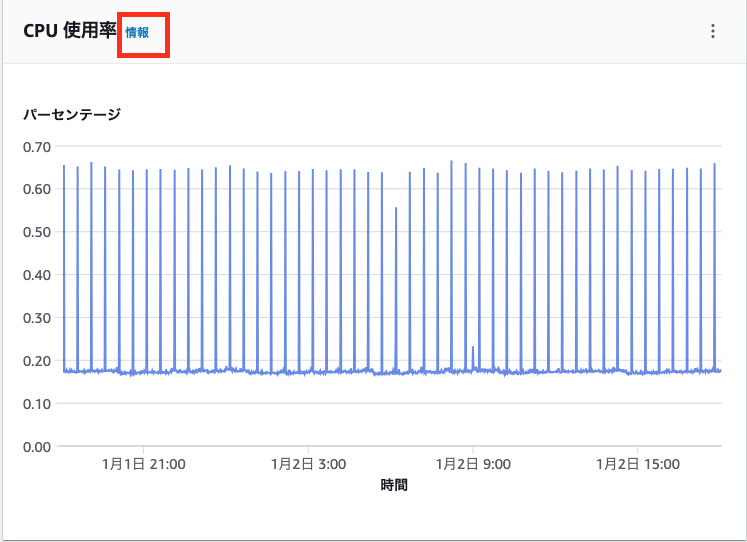

- SageMakerã®CPU・GPU利用率

- コア数 × 100%ãŒä¸Šé™ã«ãªã‚Šã¾ã™ã€‚例ãˆã°ã€

ml.g4dn.4xlargeã®ã‚¤ãƒ³ã‚¹ã‚¿ãƒ³ã‚¹ã‚’使ã£ã¦ã„ã‚‹å ´åˆã€CPU: 16, GPU:1 ã®ãŸã‚ã€CPUã®åˆ©ç”¨çŽ‡ã®ç¯„囲㯠0% ~ 1600% ã«ãªã‚Šã¾ã™ã€‚AWSã®ã€Œãƒ¢ãƒ‹ã‚¿ãƒªãƒ³ã‚°ã€ã‚’使ã£ã¦ç¢ºèªã—ã¦ã„ã‚‹å ´åˆã€ã€Œæƒ…å ±ã€ã§å„メトリクスã®èª¬æ˜Žã‚’見るã“ã¨ãŒã§ãã¾ã™ã€‚

- コア数 × 100%ãŒä¸Šé™ã«ãªã‚Šã¾ã™ã€‚例ãˆã°ã€

- JVMã‚„OpenSearchã®ãƒ¡ãƒ¢ãƒªåˆ©ç”¨çŽ‡

JVMã§ã¯ãƒªã‚¯ã‚¨ã‚¹ãƒˆæ•°ã«å¿œã˜ã¦å¾ã€…ã«ãƒ¡ãƒ¢ãƒªåˆ©ç”¨çŽ‡ãŒã‚ãŒã‚‹ã‚ã‘ã§ã¯ãªãã€æœ€åˆã«JVM引数ã§æŒ‡å®šã•ã‚ŒãŸã‚µã‚¤ã‚ºã‚’一括ã§ç¢ºä¿ã—ã¾ã™ã€‚ãã®ãŸã‚ã€ãƒ¡ãƒ¢ãƒªåˆ©ç”¨çŽ‡ã ã‘ã§ã¯ãªããƒ’ãƒ¼ãƒ—é ˜åŸŸã®å‰²ã‚Šå½“ã¦ã‚‚確èªã™ã‚‹å¿…è¦ãŒã‚ã‚Šã¾ã™ã€‚OpenSearchã§ã‚‚JVMを利用ã—ã¦ã„ã‚‹ãŸã‚ã€ãƒ¡ãƒ¢ãƒªåˆ©ç”¨çŽ‡ã¯ãƒªã‚¯ã‚¨ã‚¹ãƒˆãŒãªã„時ã§ã‚‚高ã„値ã«ãªã£ã¦ã„ã‚‹ã“ã¨ãŒã‚ã‚Šã¾ã™ã€‚メモリ利用率ã§ã¯ãªãã€ä»¥ä¸‹ã‚’確èªã™ã‚‹æ–¹ãŒã‚ˆã„よã†ã§ã™ã€‚

・VM メモリプレッシャー

・CPU 使用率

・空ãã‚¹ãƒˆãƒ¬ãƒ¼ã‚¸é ˜åŸŸ

å‚考:

JavaのGCの仕組みを整理する #Java - Qiita

Amazon OpenSearch Service で高い sysMemoryUtilization をトラブルシューティングする | AWS re:Post

- OpenSearchã®æ¤œç´¢ãƒ¬ã‚¤ãƒ†ãƒ³ã‚·ãƒ¼

AWSã«å•ã„åˆã‚ã›ã‚’è¡Œã£ãŸã¨ã“ã‚ã€CloudWatch メトリクスã®Â 検索レイテンシー(SearchLatency )ã¯ãƒªã‚¯ã‚¨ã‚¹ãƒˆã€œãƒ¬ã‚¹ãƒãƒ³ã‚¹ã¾ã§ã®æ™‚é–“ã§ã¯ãªã„ã¨ã®ã“ã¨ã ã£ãŸã®ã§æ³¨æ„ãŒå¿…è¦ã§ã™ã€‚(リクエスト〜レスãƒãƒ³ã‚¹ã¾ã§ã®æ™‚é–“ = クエリãŒã‚¯ã‚¨ãƒªãƒ•ã‚§ãƒ¼ã‚ºã§è²»ã‚„ã—ãŸæ™‚é–“ + フェッãƒãƒ•ã‚§ãƒ¼ã‚ºã®æ™‚é–“ + ã‚ューã§è²»ã‚„ã—ãŸæ™‚é–“ + ãƒãƒƒãƒˆãƒ¯ãƒ¼ã‚¯ãƒ¬ã‚¤ãƒ†ãƒ³ã‚·ãƒ¼ ã‹ã‚‰ãªã‚‹ã¨ã®ã“ã¨ã§ã™ãŒã€ãã®ã†ã¡ã‚¯ã‚¨ãƒªãƒ•ã‚§ãƒ¼ã‚ºã§è²»ã‚„ã—ãŸæ™‚é–“ ã ã‘を表ã—ã¦ã„ã‚‹ã¨ã®ã“ã¨ã§ã™ã€‚)

ãã®ä»–

- 試験æ¡ä»¶ãŒæœ¬ç•ªç’°å¢ƒã¨è¿‘ã„æ¡ä»¶ã«ãªã£ã¦ã„ã‚‹ã‹ç¢ºèªã™ã‚‹

テストデータã®åã‚Šã«ã‚ˆã‚Šã‚ャッシュãŒä½¿ã‚ã‚Œã€æƒ³å®šã™ã‚‹è² è·ã‚’ã‹ã‘られã¦ã„ãªã„ã“ã¨ãŒã‚ã‚Šã¾ã—ãŸã€‚テストデータを作æˆã™ã‚‹å‰ã«ã€åˆ©ç”¨ã™ã‚‹ãƒªã‚½ãƒ¼ã‚¹ã«ã‚ャッシュãŒã‚ã‚‹ã®ã‹ã€ã‚ã‚‹å ´åˆã¯ä½•å˜ä½ã§ã©ã‚Œãらã„ã®æ™‚é–“ã‚ャッシュãŒåŠ¹ãã®ã‹ã‚’確èªã™ã‚‹å¿…è¦ãŒã‚ã‚Šã¾ã—ãŸã€‚ãã®ä»–ã€ãƒªã‚¯ã‚¨ã‚¹ãƒˆå†…容やDBデータé‡ã€ãƒ¦ãƒ¼ã‚¶ãƒ¼æ•°ãªã©ãŒæœ¬ç•ªæƒ³å®šã«è¿‘ã„状態ã«ãªã£ã¦ã„ã‚‹ã‹ã‚‚確èªãŒå¿…è¦ã§ã—ãŸã€‚

- æ–°ã—ã„ライブラリを使ã†å ´åˆã¯ã€è² è·ã«è€ãˆã‚‰ã‚Œã‚‹ã‹æ—©ã‚ã«ç¢ºèªã™ã‚‹

é€šå¸¸è² è·ãƒ†ã‚¹ãƒˆã¯ã€å®Ÿè£…・çµåˆãƒ†ã‚¹ãƒˆå®Œäº†å¾Œã€ç·åˆãƒ†ã‚¹ãƒˆã¨ã—ã¦ãƒªãƒªãƒ¼ã‚¹ã«è¿‘ã„段階ã§è¡Œã†ã“ã¨ãŒå¤šã„ã§ã™ãŒã€ã‚るライブラリを利用ã—ãŸæ™‚ã«è² è·ã‚’ã‹ã‘ãŸå ´åˆã®ã¿æ™‚折エラーãŒç™ºç”Ÿã—ã€è§£æ±ºã§ããšã«çµå±€ãƒ©ã‚¤ãƒ–ラリを使ã‚ãªã„方法ã§å†å®Ÿè£…ã™ã‚‹ã“ã¨ã«ãªã£ãŸã“ã¨ãŒã‚ã‚Šã¾ã—ãŸã€‚æ–°ã—ã„ライブラリを使ã†å ´åˆã¯ã€é¸å®šæ™‚ã«è² è·ã«è€ãˆã‚‰ã‚Œã‚‹ã‹ã‚’ã§ãã‚‹ã ã‘æ—©ã‚ã«æ¤œè¨¼ã—ãŸæ–¹ãŒè‰¯ã„ã¨æ„Ÿã˜ã¾ã—ãŸã€‚

ãŠã‚ã‚Šã«

åŠå¹´é–“ã§ä»–ã®ãƒ¡ãƒ³ãƒãƒ¼ã®æ–¹ã«ã‚‚æ•™ãˆã¦ã‚‚らã„ãªãŒã‚‰è‰²ã€…å¦ã³ã¾ã—ãŸãŒã€ã¾ã ã¾ã å¦ã¶ã“ã¨ãŒã‚ã‚Šãã†ã§ã™ã€‚効率的ã«è² è·ãƒ†ã‚¹ãƒˆã‚’è¡Œãªã£ã¦å®‰å¿ƒã—ã¦å®‰å®šé‹ç”¨ã§ãるよã†ã«ã—ã¦ã„ããŸã„ã§ã™ã€‚ ã‚ã™ã‘ã‚“ã®æˆé•·ã‚¹ãƒ”ードã¯æ¯Žå¹´ã‚ãŒã£ã¦ãŠã‚Šã€2024å¹´3月ã«ç´¯è¨ˆä¼šå“¡æ•°1,000万人をçªç ´ã—ã¦ã‹ã‚‰ç´„6カ月後ã«ã¯1,100万人ã¨ãªã‚Šã¾ã—ãŸã€‚多ãã®ä¼šå“¡æ§˜ã«ä½¿ã£ã¦ã„ãŸã ãサービスを支ãˆã‚‹é›£ã—ã•ã¨ã¨ã‚‚ã«ã€å¤§é‡ã®ãƒªã‚¯ã‚¨ã‚¹ãƒˆã‚’æŒãサービスãªã‚‰ã§ã¯ã®ã‚„ã‚ŠãŒã„ã‚‚æ„Ÿã˜ã¦ã„ã¾ã™ã€‚

askenã§ã¯ã‚¨ãƒ³ã‚¸ãƒ‹ã‚¢ã‚’絶賛募集ä¸ã§ã™ã€‚ãœã²ãŠæ°—軽ã«ã”連絡ãã ã•ã„ï¼